Indholdsfortegnelse:

Video: Hvordan betjener du en TensorFlow-model?

2024 Forfatter: Stanley Ellington | [email protected]. Sidst ændret: 2023-12-16 00:15

For at tjene en Tensorflow-model , skal du blot eksportere en SavedModel fra din Tensorflow program. SavedModel er et sprogneutralt, gendanbart, hermetisk serialiseringsformat, der gør det muligt for systemer og værktøjer på højere niveau at producere, forbruge og transformere TensorFlow modeller.

Derfor, hvordan kører jeg en TensorFlow-model?

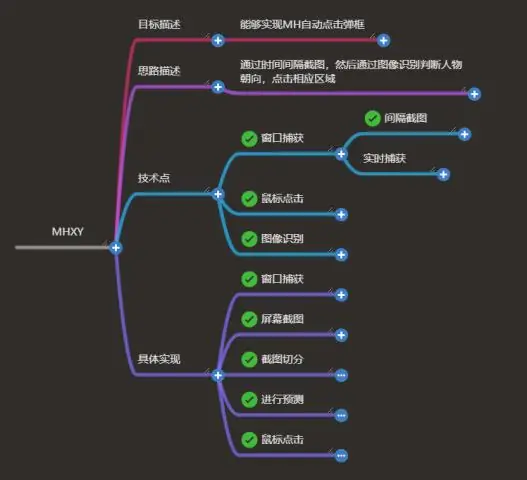

Disse trin skal vi gøre:

- Lav en dum model som eksempel, træne og opbevar den.

- Hent de variabler, du har brug for, fra din gemte model.

- Byg tensorinformationen ud fra dem.

- Opret modelsignaturen.

- Opret og gem en modelbygger.

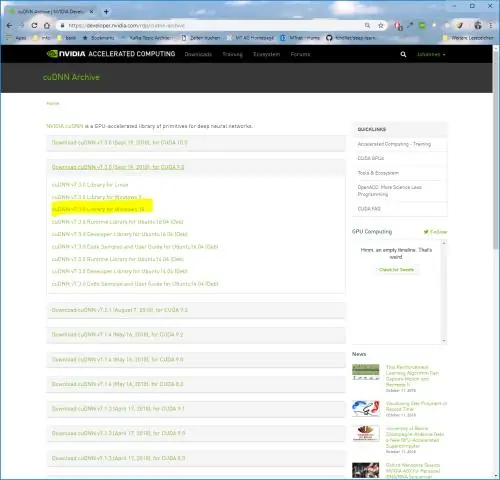

- Download et Docker-billede med TensorFlow-servering allerede kompileret på det.

Derudover, hvad serverer TensorFlow? TensorFlow-servering er en fleksibel, højtydende betjener system til maskinlæringsmodeller, designet til produktionsmiljøer. TensorFlow-servering giver out-of-the-box integration med TensorFlow modeller, men kan nemt udvides til tjene andre typer modeller og data.

Hvad angår dette, hvordan fungerer TensorFlow-serveren?

TensorFlow-servering giver os mulighed for at vælge, hvilken version af en model eller "serverbar" vi vil bruge, når vi foretager slutningsanmodninger. Hver version vil blive eksporteret til en anden undermappe under den givne sti.

Hvad er en modelserver?

Model server til Apache MXNet (MMS) er en open source-komponent, der er designet til at forenkle opgaven med at implementere deep learning modeller til slutning i skala. Udruller modeller for slutning er ikke en triviel opgave.

Anbefalede:

Hvordan initialiserer du en TensorFlow -variabel?

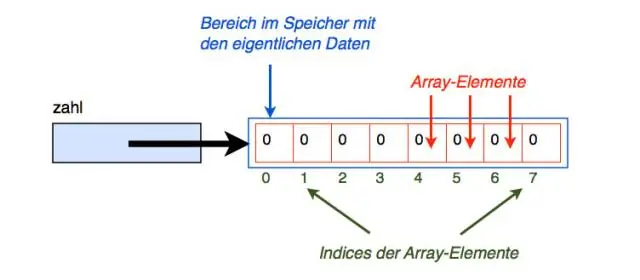

For at initialisere en ny variabel fra værdien af en anden variabel skal du bruge den anden variabels egenskab initialized_value (). Du kan bruge den initialiserede værdi direkte som startværdien for den nye variabel, eller du kan bruge den som enhver anden tensor til at beregne en værdi for den nye variabel

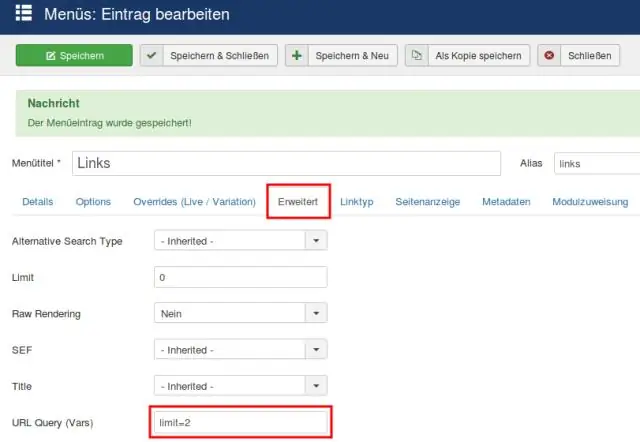

Hvordan gemmer du en TensorFlow-graf?

TensorFlow gemmer i/indlæser en graf fra en fil Gem modellens variabler i en checkpoint fil (. ckpt) ved hjælp af en tf. Gem en model i en. pb-fil og indlæs den igen ved hjælp af tf. Indlæs en model fra en. Frys grafen for at gemme grafen og vægtene sammen (kilde) Brug as_graph_def() for at gemme modellen, og for vægte/variabler kortlægges dem i konstanter (kilde)

Hvad er.PB fil TensorFlow?

Pb står for protobuf. I TensorFlow indeholder protbuf-filen grafdefinitionen såvel som modellens vægte. En pb-fil er således alt hvad du behøver for at kunne køre en given trænet model. Givet en pb-fil, kan du indlæse den som følger

Hvordan genbruger du variabler i TensorFlow?

Afsluttende ord genbrug betyder at dele den samme variabel mellem forskellige objekter. Hvis du vil dele en variabel, anden gang du henviser til det, skal du udtrykkeligt angive "genbrug=Sand" i variabelområdet for den variabel, du vil genbruge, eller. indstil variablen omfang til "genbrug=tf.AUTO_REUSE"

Hvordan viser du en TensorFlow-graf?

For at se din egen graf skal du køre TensorBoard og pege den på opgavens logbibliotek, klikke på graffanen i den øverste rude og vælge den relevante kørsel ved hjælp af menuen i øverste venstre hjørne